No nosso último encontro, desvendamos os Mecanismos de Atenção, o coração pulsante dos modernos modelos de linguagem, que nos permite ter sistemas de IA que “enxergam” e compreendem o contexto como nunca antes. Mas se a atenção resolveu o problema do “foco”, como lidamos com o desafio de construir modelos cada vez maiores, com bilhões (ou trilhões!) de parâmetros, sem que o custo computacional e o consumo de energia explodam para a estratosfera?

A resposta para essa questão cada vez mais relevante nos leva a uma ideia que, embora não seja nova, ganhou uma relevância monumental nos últimos anos: as Mixture-of-Experts (MoE). Prepare-se para conhecer uma arquitetura que, em vez de criar um único “gênio universal”, aposta na sabedoria das massas – ou, mais precisamente, na especialização.

O dilema do “Gênio Universal”: Por que modelos gigantes nem sempre são a melhor resposta

Tradicionalmente, para tornar um modelo de IA mais poderoso, a receita era clara: adicione mais parâmetros. Modelos maiores tendem a ter mais capacidade de memorização, aprendem padrões mais complexos e, em geral, performam melhor em uma vasta gama de tarefas. É a ideia de que um único e gigantesco cérebro pode processar todas as informações e resolver todos os problemas.

No entanto, essa estratégia de “gênio universal” tem seus calcanhares de Aquiles:

- Custo de treinamento e inferência: Modelos densos (onde todos os parâmetros são ativados para cada previsão) consomem uma quantidade absurda de recursos computacionais. Treinar um modelo de trilhões de parâmetros é um feito que pouquíssimas organizações podem bancar. Inferir (fazer previsões) com eles também é lento e caro.

- Diluição de conhecimento: Quando um único modelo tenta aprender tudo sobre tudo, o conhecimento pode acabar sendo diluído. É como pedir a um cardiologista para realizar uma cirurgia cerebral – ele pode ter uma ideia, mas não é sua área de especialização.

Foi nesse cenário que as Mixture-of-Experts ressurgiram com força total.

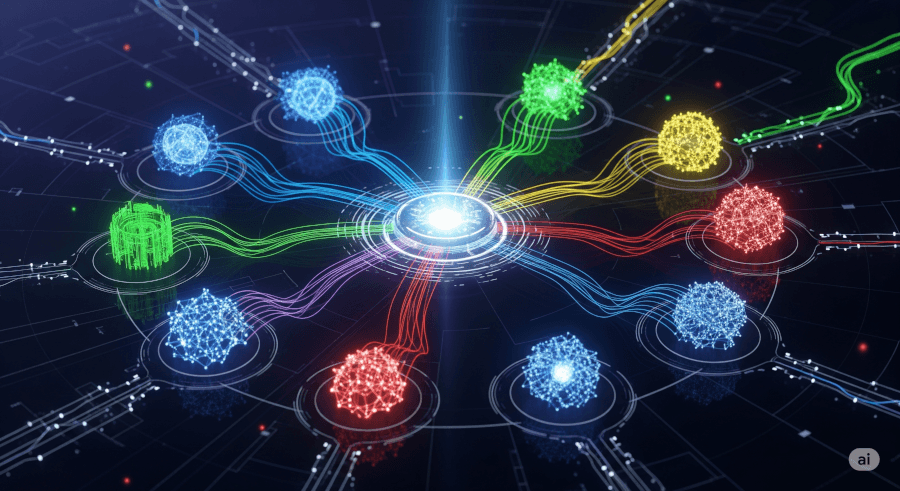

A intuição por trás das Mixture-of-Experts: O comitê de especialistas

A ideia fundamental da Mixture-of-Experts é brilhantemente simples: em vez de ter um único modelo massivo tentando resolver tudo, você tem vários modelos menores, cada um especializado em um tipo diferente de problema ou dado. E, para gerenciar esses especialistas, existe um “porteiro” inteligente que direciona cada tarefa para o especialista mais adequado.

Pense em um consultório médico de elite. Em vez de um único clínico geral tentando diagnosticar e tratar todas as doenças, você tem:

- Um cardiologista (especialista em coração)

- Um neurologista (especialista em cérebro)

- Um pediatra (especialista em crianças)

- Um dermatologista (especialista em pele)

E na recepção, uma secretária inteligente (que aqui chamaremos de Router ou Gate) que, ao ouvir os sintomas do paciente, decide imediatamente para qual especialista o paciente deve ser encaminhado. Se o paciente está com dor no peito, a secretária o envia para o cardiologista. Se é uma erupção na pele, para o dermatologista.

| Conceito MoE | Analogia do Consultório Médico |

| Input (Entrada) | O paciente com seus sintomas |

| Experts | Os médicos especialistas (cardiologista, etc.) |

| Router (Gate) | A secretária inteligente na recepção |

| Output (Saída) | O diagnóstico e tratamento do especialista |

Componentes-Chave de uma arquitetura MoE

Uma arquitetura Mixture-of-Experts é composta por dois elementos principais:

- Experts (Especialistas): São as redes neurais propriamente ditas. Em modelos de linguagem, geralmente são Feed-Forward Networks (FFNs) densas, mas poderiam ser redes convolucionais para imagens, ou qualquer outro tipo de sub-rede. O importante é que há várias delas, e cada uma idealmente se especializa em um tipo de padrão ou sub-problema.

- Gate ou Router: Este é o cérebro que decide. É uma rede neural menor que recebe a entrada e, com base nela, calcula quais experts (geralmente um ou dois, mas pode ser mais) devem ser ativados para processar aquela entrada específica. Ele gera uma série de pesos, indicando a “confiança” em cada expert para a tarefa atual.

Como o router faz a mágica?

O Router é a peça crucial que diferencia o MoE de simplesmente ter vários modelos e escolher um. Ele aprende a fazer a decisão de roteamento durante o treinamento.

Um Router comum é implementado como uma camada linear seguida por uma função Softmax (ou Softmax Esparso) que produz uma distribuição de probabilidades sobre os experts.

Se o Router escolhe apenas os k experts com as maiores probabilidades (top-k routing), a saída do bloco MoE será uma soma ponderada das saídas dos experts selecionados. Isso significa que, para uma dada entrada, apenas uma pequena fração dos parâmetros totais do modelo é ativada, levando a ganhos significativos em eficiência computacional durante a inferência.

As vantagens inegáveis das Mixture-of-Experts

Os benefícios da arquitetura Mixture-of-Experts são transformadores:

- Escalabilidade sem precedentes: É possível criar modelos com bilhões ou até trilhões de parâmetros, enquanto o custo de inferência permanece comparável ao de modelos densos muito menores. Isso ocorre porque apenas uma parte dos parâmetros é utilizada por vez. Imagine ter um “armário” de conhecimentos gigantesco, mas só abrir a gaveta que você precisa, em vez de vasculhar tudo.

- Eficiência computacional: Como mencionado, o número de FLOPs (Floating Point Operations Per Second) necessários para processar uma entrada é drasticamente reduzido. Isso torna a inferência mais rápida e mais barata.

- Capacidade aumentada: Com a possibilidade de adicionar mais experts sem aumentar o custo de inferência, os modelos MoE podem aprender uma gama mais vasta de padrões e conhecimentos, tornando-os mais capazes e versáteis.

- Especialização: A arquitetura incentiva os experts a se especializarem em diferentes subconjuntos de dados ou tipos de problemas, levando a representações mais ricas e eficientes do conhecimento.

Desafios e armadilhas da Mixture-of-Experts

Nem tudo são flores no jardim dos MoE. Existem desafios consideráveis:

- Balanceamento de carga dos experts: É um problema comum que alguns experts se tornem “preguiçosos” e sejam escolhidos raramente, ou que um ou poucos experts se tornem “sobrecarregados”, processando a maioria das entradas. Isso leva ao colapso do expert ou ao desequilíbrio, onde a capacidade total do modelo não é utilizada. Para combater isso, são usadas funções de perda adicionais (como load balancing loss) que penalizam o roteador por não distribuir o trabalho de forma equitativa.

- Treinamento do eouter: O router precisa aprender a direcionar corretamente as entradas, o que pode ser um processo complexo. Um router ineficiente pode anular os benefícios do MoE.

- Complexidade de implementação e distribuição: Treinar e implantar modelos MoE exige infraestrutura e estratégias de paralelização mais sofisticadas, pois os experts precisam ser distribuídos eficientemente em múltiplos dispositivos ou servidores. Gerenciar a esparsidade das ativações é crucial.

- Overhead de comunicação: Embora menos parâmetros sejam ativados, a comunicação entre os experts (se estiverem em dispositivos diferentes) pode adicionar overhead de latência.

MoE no mundo real: Onde encontramos essa magia?

As Mixture-of-Experts não são mais apenas um conceito acadêmico. Elas estão no cerne de alguns dos maiores avanços em IA:

- Google: Tem sido uma das principais impulsionadoras da pesquisa em MoE, com modelos como o Switch Transformer, GLaM (Generalist Language Model) e mais recentemente o Gemini, utilizando amplamente essa arquitetura para alcançar escalas e capacidades sem precedentes.

- DeepMind: Também explorou extensivamente os MoE em seus modelos, mostrando ganhos significativos em eficiência e desempenho.

- OpenAI: Embora o foco público seja nos modelos densos como o GPT-3 e GPT-4, há indícios e pesquisas que sugerem a exploração de MoE em suas arquiteturas para maior eficiência.

Gostou do artigo? Conte nos comentários o que você acha da abordagem MoE, e se já utilizou em algum projeto. Aproveite para compartilhar este artigo para difundir o conhecimento sobre IA e ML.