Descubra como a IA está criando imagens hiper-realistas a partir do nada — literalmente. Entenda os modelos de difusão, por que superaram as GANs e como você pode gerar suas próprias imagens com poucas linhas de código.

🧠 O que é um modelo de difusão?

Um modelo de difusão é uma técnica de geração de imagens baseada em um processo de “desfazer o ruído”. Pense como um mágico reverso: em vez de transformar um coelho em um chapéu, ele pega puro ruído aleatório e vai “limpando” até revelar uma imagem coerente — tipo um scanner 3D que começa com o barulho e termina com a Mona Lisa.

Esse processo tem duas etapas principais:

- Difusão direta: a imagem original é destruída gradualmente com ruído gaussiano.

- Difusão reversa (geração): a IA aprende a reverter esse processo, reconstruindo a imagem original do caos.

Essa abordagem é inspirada em física estatística, mas calma, não precisa saber termodinâmica pra entender — você só precisa saber que a IA aprende a “imaginar o que havia ali antes do barulho”.

🤖 Por que os modelos de difusão superaram as GANs?

Durante anos, as GANs (Generative Adversarial Networks) reinaram soberanas na geração de imagens. Mas elas têm problemas crônicos como:

- Modo colapso (a IA só gera um mesmo tipo de imagem)

- Dificuldade de controle sobre o resultado

- Treinamento instável

Já os modelos de difusão:

- São mais estáveis no treinamento

- Permitem controle fino sobre o processo de geração

- Produzem resultados mais detalhados e realistas

📘 Estudos como o artigo do Stable Diffusion (Rombach et al., 2022) e o Denoising Diffusion Probabilistic Models (Ho et al., 2020) mostraram empiricamente que os modelos de difusão batem as GANs em qualidade e diversidade.

📸 Como gerar imagens com IA usando Stable Diffusion (com código!)

Agora vamos ao que interessa: como gerar imagens com IA usando um modelo de difusão real.

Vamos usar o Stable Diffusion via a biblioteca diffusers da Hugging Face — a forma mais prática e amigável de brincar com isso.

⚠️ Pré-requisitos:

- Python 3.9+

- GPU com pelo menos 6GB de VRAM (ou use o Google Colab)

🔧 Instalação das bibliotecas

pip install diffusers transformers accelerate safetensors🖼️ Código completo para gerar uma imagem

from diffusers import StableDiffusionPipeline

import torch

# Autenticação com HuggingFace (requer criar token gratuito)

from huggingface_hub import login

login(token="SEU_TOKEN_AQUI")

# Carrega o modelo Stable Diffusion

pipe = StableDiffusionPipeline.from_pretrained(

"runwayml/stable-diffusion-v1-5",

torch_dtype=torch.float16,

use_safetensors=True

).to("cuda")

# Prompt de entrada

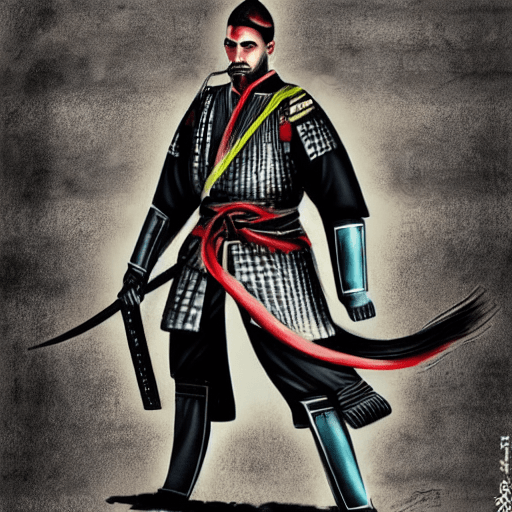

prompt = "um guerreiro samurai futurista em chamas, estilo pintura digital"

# Geração da imagem

image = pipe(prompt).images[0]

# Mostra e salva a imagem

image.show()

image.save("samurai.png")

💡 Dica de uso: prompts criativos fazem a diferença!

Aqui vão alguns prompts que você pode testar:

"castelo flutuante steampunk ao pôr do sol""paisagem alienígena com plantas bioluminescentes, estilo estúdio Ghibli"

📚 De onde vem esse poder? O segredo do Latent Diffusion

O Stable Diffusion não trabalha com pixels diretamente. Ele codifica a imagem em um espaço latente comprimido com um autoencoder, o que permite gerar imagens de forma muito mais eficiente.

Essa técnica se chama Latent Diffusion Models (LDM) e foi a grande inovação do time de pesquisadores da CompVis em 2022. Eles conseguiram reduzir drasticamente o custo computacional da geração mantendo alta qualidade.

🧪 Resultados e aplicações no mundo real

Empresas e artistas já estão usando modelos de difusão em:

- Design de produto (ex: gerar rascunhos visuais)

- Conceito de personagens e cenários

- Marketing visual (anúncios com variações rápidas)

- Jogos indie (criação procedural de itens e ambientes)

Quer um exemplo legal? O jogo indie “This Girl Does Not Exist” usou IA para gerar rostos realistas de NPCs com base em prompts dinâmicos — algo que seria impensável há poucos anos.

⚖️ E os desafios? (Nem tudo são pixels brilhantes)

- Tempo de inferência: ainda é mais lento que GANs em alguns casos.

- Ética e direitos autorais: modelos como o Stable Diffusion foram treinados em bancos de dados que contêm obras protegidas.

- Controle de conteúdo: há riscos de geração de imagens inadequadas sem filtros.

🚀 Conclusão: O futuro da criatividade está se desenhando — literalmente

Modelos de difusão como o Stable Diffusion são um salto quântico na geração de imagens. Eles não apenas superam modelos anteriores em qualidade, mas abrem portas para novas formas de criar, especialmente em design, arte e desenvolvimento de jogos.

Com ferramentas acessíveis e código open source, você já pode usar esse poder criativo hoje mesmo.

💬 Agora é com você!

Curtiu descobrir como a IA está criando imagens do zero? Já teve alguma ideia maluca de prompt que gostaria de testar com Stable Diffusion?

👇 Compartilha aí nos comentários! Quero saber o que você achou, se já usou IA generativa ou se vai começar agora.

E se este post te ajudou a entender melhor o que está por trás dessa tecnologia incrível, compartilhe com seus amigos devs, artistas ou curiosos por IA — quem sabe você não inspira alguém a criar a próxima obra-prima gerada por máquina?

🔁 Espalhe o conhecimento. Uma linha de código hoje pode virar arte amanhã. 🚀